SCIENCES - HAUTES TECHNOLOGIES : LES ORDINATEURS QUANTIQUES SERONT-ILS DEMAIN LES PLUS PUISSANTS DU MONDE INFORMATIQUE

Honeywell a-t-il créé l’ordinateur quantique le plus puissant du monde ?

Publié le 11 mars 2020 - Commenter -

Le 2 mars 2020, Honeywell annonçait avoir mis au point un ordinateur quantique qui serait le plus puissant du monde et doublerait la puissance par rapport au record précédent qui serait détenu par IBM. La communication initiale d’Honeywell a été reprise à l’unisson par les médias du monde entier. Ca flashait bien et faisait suite à l’annonce remarquée de la suprématie quantique de Google en septembre/octobre 2019.

Évidemment, cette annonce aiguise la curiosité. Est-elle documentée techniquement ? Peut-on s’en faire une idée plus précise ? Est-ce que le volume quantique d’IBM rime à quelque chose ? Cette annonce est-elle exagérée ? Est-ce une annonce significative ? Peut-on en tirer des leçons pour les efforts français dans les technologies quantiques ? Réponses : six fois oui ! Que nous allons détailler ici même. Accrochez-vous, c’est un peu technique au début mais les dernières parties le sont beaucoup moins !

Sources d’information techniques

On peut commencer par accéder à quelques sources d’informations détaillées :

Une publication scientifique qui décrit dans le détail la performance d’Honeywell : Demonstration of the QCCD trapped-ion quantum computer architecture par J. M. Pino & Al, 2020 (8 pages) ainsi que ses perspectives. Celle-ci n’est en effet qu’une étape d’un parcours qui n’est pas terminé. Par rapport à la documentation de la suprématie quantique de Google, les informations fournies sont moins abondantes. On sent qu’Honeywell préserve ses arrières et ne dévoile pas tout. Il faut préciser que ce document n’est pas encore passé par une relecture par comité d’auteur. Il n’est publié pour l’instant que sur Arxiv.

La présentation Shaping the future of quantum computing de Tony Uttley, le patron de l’équipe quantique d’Honeywell. Elle avait lieu lors de la conférence Q2B organisée par la startup QcWare à San Jose en Californie du 10 au 12 décembre 2019 (slides). Y participaient notamment Iordanis Kerenidis (QcWare, CNRS, et aussi membre de la mission quantique de Paula Forteza) et Christophe Jurczak (Quantonation).

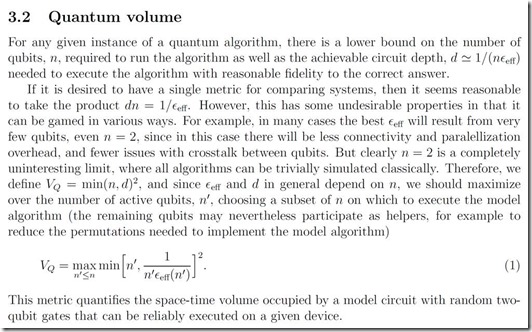

La notion de volume quantique est définie dans Quantum Volume de Lev Bishop, Sergey Bravyi, Andrew Cross, Jay Gambetta et John Smolin, 2017 (5 pages). Dans A volumetric framework for quantum computer benchmarks, février 2019 (24 pages), Robin Blume-Kohout et Kevin Young proposent des benchmarks volumiques pour évaluer la performance des ordinateurs quantiques en s’appuyant sur le volume quantique d’IBM. Ce dernier propose aussi son propre code d’évaluation du volume quantique.

Ces sources d’information permettent de bien examiner l’annonce en question, que je fais dans ce qui suit. Cela m’a demandé un peu de recherche documentaire sur certains domaines de la physique qui m’étaient méconnus et aussi de me faire aider par quelques physiciens, cités en fin d’article.

Volume quantique

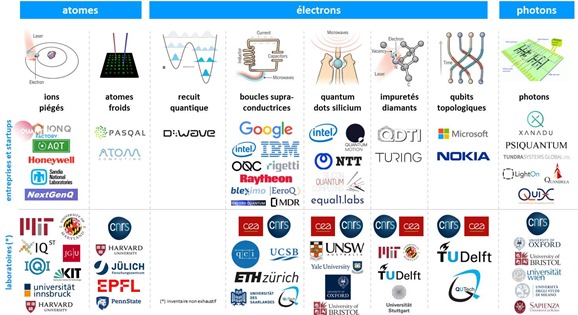

L’annonce d’Honeywell porte sur la création d’un processeur quantique de quatre qubits à base d’ions piégés, l’une des technologies de qubits actuellement explorée à côté notamment des circuits supraconducteurs (IBM, Google, Rigetti, Intel, …), des photons (PsiQuantum, …), des atomes froids (Pasqal en France) et du silicium (CEA-Leti, Intel).

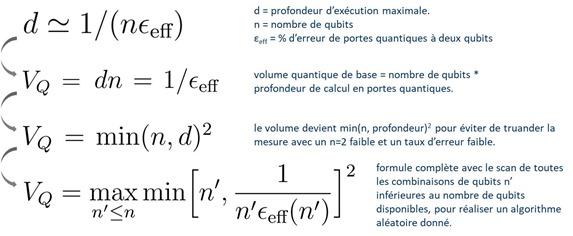

Le doublement de la puissance est évalué par un nombre entier, le volume quantique, proposé par IBM en 2017, qui associe la quantité de qubits et le nombre de portes quantiques qui peuvent être exécutées consécutivement sans que les erreurs qui s’accumulent soient préjudiciables à la précision des calculs. En effet, disposer de n qubits mais être limité par le nombre de portes quantiques que l’on peut enchaîner peut être préjudiciable à l’exécution de nombreux algorithmes quantiques. Certains sont gourmands en portes quantiques, d’autres non. A ce jour, seuls IBM et Honeywell utilisent cette notion de volume quantique pour décrire la puissance de leurs processeurs quantiques.

Comme la qualité des qubits d’Honeywell serait meilleure avec un faible taux d’erreurs, cela leur permettrait de faire mieux qu’IBM avec ses 28 qubits annoncés lors du CES 2020. Ceci étant, 4 ou 8 qubits, même de qualité, ne servent pas à grand-chose. Il faut dépasser 50 qubits pour pouvoir réaliser des calculs complètement inaccessibles aux supercalculateurs d’aujourd’hui. Honeywell indique cependant pouvoir augmenter ce nombre tout en préservant la qualité des qubits. Cela reste à démontrer.

Honeywell pense ainsi pouvoir atteindre rapidement un volume quantique de 64 à comparer au volume quantique record d’IBM qui serait de 32 et qui date de janvier 2020. En fait, Honeywell mettait un peu la charrue avant les bœufs car pour l’instant, ils en sont à un volume quantique de 16 avec visiblement seulement 4 qubits. Le volume quantique de 64 est une promesse pour la mi-2020. Ils n’indiquent d’ailleurs pas précisément comment ils envisagent de passer de 16 à 64 ! On dirait qu’il s’agit de passer de 4 à 8 qubits.

Là-dessus, j’ai essayé de comprendre à quoi correspondait exactement ce volume quantique d’IBM. Autant dire que c’est loin d’être trivial. Ce volume quantique est censé évaluer la performance d’un processeur quantique avec un seul nombre entier. C’est donc en apparence très simple. Mais dès que l’on cherche à comprendre d’où vient ce nombre magique, les choses se compliquent.

Ce nombre agrège quatre facteurs clés de performance :

- Le nombre de qubits physiques du processeur. Le record aujourd’hui est de 53 chez Google et IBM.

- Le nombre de portes quantiques qui peuvent être enchaînées consécutivement sans que le taux d’erreur soit préjudiciable aux résultats.

- La connectivité entre les qubits.

- Le nombre d’opérations qui peuvent être réalisées en parallèle.

Une autre définition du volume quantique est la dimension de l’espace de calcul accessible par le processeur. Cela devient le nombre maximum de qubits sur lequel le processeur peut générer un état aléatoire (combinaison d’états de qubits)… et élevé au carré.

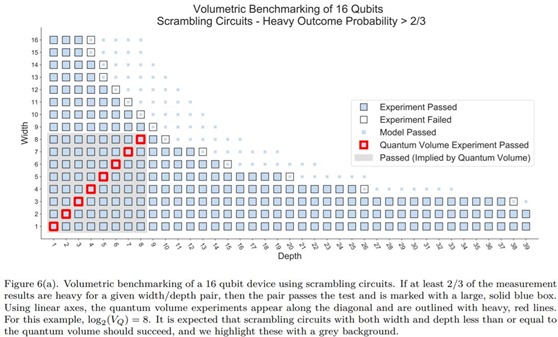

On retrouve cette notion dans le schéma ci-dessous issu du document déjà cité de Robin Blume-Kohout et Kevin Young. Leur benchmark est réalisé avec une combinaison de nombres de qubits inférieurs au nombre de qubits du processeur, 16 dans ce cas, et de séries de portes quantiques enchaînées, jusqu’à 38 dans le cas présent. Le volume quantique devient la surface du carré en gris contenant les carrés entourés de rouge. Il s’appuie sur le nombre de qubits permettant d’exécuter un algorithme aléatoire avec une profondeur de calcul égale à au moins ce même nombre de qubits. Cela correspond à ce que l’on appelle un “circuit carré”, lorsque le nombre de portes enchaînées est égal au nombre de qubits dans sa représentation graphique temporelle classique. Et il faut dans le benchmark que l’on ait une probabilité de 2/3 d’obtenir le bon résultat.

D’un point de vue géométrique, ce carré semble être le plus souvent le rectangle de plus grande surface qu’il est possible d’inscrire à partir du coin en bas à gauche et dans la zone en bleu foncé qui correspond aux tests réalisés avec succès.

Ce volume quantique est une valeur un peu arbitraire. En effet, certains algorithmes peuvent se satisfaire d’un nombre limité de portes quantiques, comme celui de Deutsch-Jozsa qui sert à vérifier qu’une fonction est équilibrée ou pas (générant une fois sur deux 0 ou 1 ou tout le temps 0 ou 1), et se contente de seulement quatre séries de portes quantiques. A l’inverse, le fameux algorithme de factorisation de nombres entiers de Peter Shor requiert un nombre de séries de portes quantiques égal au cube du nombre de qubits utilisés.

Le schéma de Robin Blume-Kohout et Kevin Young permet de mieux comprendre le processus de création de la formule du volume quantique d’IBM que j’ai décomposé ci-dessous :

Ce schéma ci-dessus vise à rendre plus ou moins compréhensible la définition d’IBM que voici :

Chez IBM, le volume quantique de certains de leurs processeurs quantiques n’est pas toujours un entier au carré ! C’est donc peut-être un rectangle au lieu d’être un carré dans le schéma un peu plus haut, avec une profondeur de calcul plus grande que le nombre de qubits, ce qui peut se concevoir avec des qubits en faible nombre et de très bonne qualité.

L’usage du volume quantique est contesté par le fameux spécialiste des théories de la complexité et des algorithmes quantiques Scott Aaronson dans Turn down the quantum volume publié juste après l’annonce d’Honeywell. Il rappelle que le volume quantique qu’Honeywell pense atteindre d’ici mi 2020 est facilement émulable dans un ordinateur classique, même dans un laptop. Ce qui n’en fait pas quelque chose de particulièrement puissant. Et tandis que le volume quantique des ordinateurs quantiques s’agrandira, bien malin sera celui qui pourra indiquer à partir de cette valeur si un ordinateur quantique est capable de résoudre son problème ou algorithme particulier !

Imaginez un indicateur de la puissance de votre laptop agrégeant la fréquence d’horloge du processeur, son nombre de cœurs, la puissance de son CPU, l RAM, la capacité de stockage, son type (disque dur, SSD) etc ? Et là, de vous demander si vous allez pouvoir utiliser efficacement votre logiciel de montage vidéo, de dérushage de photos ou de jeu vidéo sur casque de réalité augmentée !

Scott Aaronson pense donc qu’il faut éviter cette mesure du quantum volume qui est un outil de simplification marketing d’IBM et décrire précisément les caractéristiques de la machine avec son nombre de qubits, leur connectivité, le temps de cohérence, le taux d’erreur des portes quantiques, la profondeur de calcul et les besoins en ressources pour émuler l’ensemble sur un ordinateur classique. On trouve généralement ces indicateurs dans les publications scientifiques de chercheurs mais pas toujours dans la littérature marketing des constructeurs.

Les commentaires de son article sont partagés et certains de ses lecteurs apprécient ce métrique simple à retenir. D’autres pensent que ce qui compte est l’avantage quantique, que l’on obtient lorsqu’un processeur quantique est capable de réaliser une opération utile qui prendrait beaucoup plus de temps sur un supercalculateur classique, avantage qui n’est pas encore atteint à ce jour.

Vous n’avez rien compris ? Ce n’est pas bien grave, vous pouvez passer à la suite qui concerne la physique quantique du processeur d’Honeywell. Ce n’est peut-être pas plus évident à comprendre, mais c’est assez indépendant de ce que nous venons tout juste de voir. Au pire des cas, sautez ce chapitre pour passer au suivant sur l’importance de l’annonce.

Architecture technique

Passons maintenant à la physique du processeur à ions piégés d’Honeywell. Comme elle est assez originale, même vis à vis de ce que fait IonQ avec ses ions piégés, j’ai essayé d’en savoir plus. Voilà ce que j’ai pu extraire en langage plus ou moins naturel des documents de la société et de la littérature scientifique.

Trapped-ion QCCD est la dénomination de leur technique à base d’ions piégés, pour “quantum charge-coupled device”. Elle exploite des ions à base d’ytterbium, une terre rare. Ils sont couplés à des ions au baryum qui servent au refroidissement de l’ensemble. Ce CCD utilisé dans le nom de la technologie rappelle les capteurs photos CCD qui s’appuient sur une conversion de charges électriques reçues par les photosites en tension et par le transfert de l’information de photosites en photosites. Nous verrons plus loin la parenté de ce procédé avec celui du contrôle de la position des ions dans le processeur d’Honeywell.

La technique du QCCD a été conçue il y a bien longtemps par Christopher Monroe, Dave Wineland et Dave Kielpinski. Elle est décrite dans Architecture for a large-scale ion-trap, 2002 (4 pages). Le papier d’Honeywell fait état de la réutilisation de nombreux travaux issus d’autres laboratoires de recherche étalés entre 2008 et 2012.

Les ions sont générés à partir d’un jet d’atomes collimaté obtenu en chauffant une cible solide d’Ytterbium. lls sont alors “touchés” par un laser, ce qui leur enlève un électron de la couche de valence de l’atome (la dernière). Il ne reste alors plus qu’un seul électron dans cette couche donnant lieu à un ion ayant une charge positive, Yb+. Le refroidissement laser de ces ions est bien maîtrisé grâce à leur schéma de niveaux d’énergie favorable. Grâce à leur charge électrique, il est possible de piéger et déplacer ces atomes à l’aide de potentiels électrostatiques et radiofréquence. Les autres éléments pouvant être utilisés pour créer des ions piégés sont le béryllium, le magnésium, le strontium et le calcium. L’ytterbium est aussi utilisé pour créer des mémoires quantiques, mais pas dans le cas présent.

L’état quantique des ions correspond à deux états énergétiques dits “hyperfins” dûs à l’interaction entre le moment magnétique du noyau et celui des électrons de l’ion. Ces niveaux hyperfins sont aussi utilisés dans les horloges atomiques au césium. La fréquence de transition entre les deux niveaux hyperfins de l’ytterbium est de 12,6 GHz. Voir Laser-cooled ytterbium ion microwave frequency standard de S. Mulholland & Al, 2019 (16 pages). Les états hyperfins de l’ion d’ytterbium se prêtent bien au calcul quantique car ils sont très stables, ce qui leur permet d’avoir un long temps de cohérence.

Les ions du processeur quantique d’Honeywell sont des ions baladeurs ! C’est le premier cas de “flying qubits” que je rencontre qui ne sont pas à base de photons. En effet, d’habitude, les qubits à base d’électrons, d’atomes froids ou d’ions ne bougent pas (trop) là où on les installe.

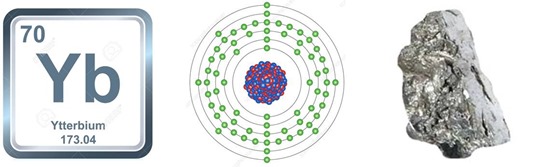

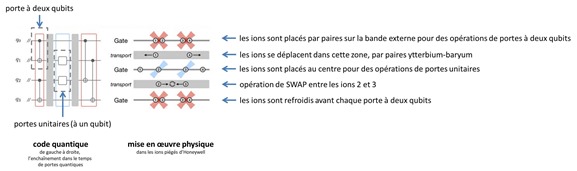

Leur système s’appuie sur un système qui prépare des atomes d’ytterbium, les ionise et les envoie dans un trou qui alimente le chipset. Ce procédé est classique. Il utilise ensuite une dizaine de zones de stockage et de tri des ions (en orange, jaune et bleu dans le schéma ci-dessous).

Les ions d’ytterbium sont confinés au-dessus d’un rail de trois rangées d’électrodes dont la tension variable permet d’en contrôler la position et de les déplacer latéralement. L’innovation de l’expérience de Honeywell est de réussir à démontrer des opérations logiques entre plusieurs qubits – ici, jusqu’à 4 – tout en les déplaçant à volonté entre des zones de stockage et des zones d’interaction pendant les opérations. Cette idée avait été proposée dès 2002 par Dave Wineland et son équipe du NIST, mais il a fallu 18 ans d’efforts continus de recherche de la communauté des ions piégés pour finalement arriver à cette prouesse technique.

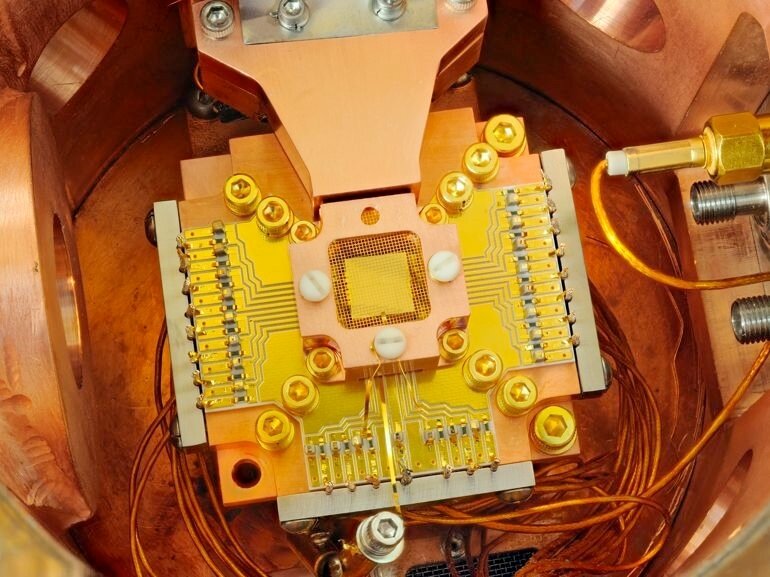

Le système utilise 198 électrodes à courant continu pour le déplacement et le positionnement des ions ytterbium qui sont couplés à des ions de baryum. La puce exploite des pièges cryogéniques de surface (“cryogenic surface trap”) qui permettent ainsi de réarranger dynamiquement le positionnement des couples d’ions ytterbium/baryum et de mettre en œuvre des portes quantiques exécutées en parallèle sur plusieurs zones du circuit.

Le schéma semble indiquer que les ions circuleraient sur la bande verte, permettant un déplacement arbitraire des ions le long de la bande. Une fois déplacés, ils seraient recasés dans la bande du milieu pour subir une porte quantique unitaire, ou dans les bandes latérales pour générer des portes quantiques à deux qubits, comme expliqué dans le schéma ci-dessous que j’ai commenté. L’une de ces opérations est une porte SWAP qui permet d’interchanger physiquement les ions.

L’inconvénient de la technique est la lenteur des portes quantiques dans les ions piégés, qui risque d’être ici encore plus marquée du fait du dispositif utilisé. Le temps de configuration des ions pour créer une porte quantique est de 3 à 5 ms ce qui n’est pas négligeable, surtout pour des algorithmes nécessitant d’enchaîner un grand nombre de portes quantiques.

Le système fonctionne à une température de 12,6K, c’est-à-dire 12,6 degrés au-dessus du zéro absolu qui est de –273,15°C. Et avec une stabilité de température de 2mK qui évite de perturber les ions et leur état quantique superposé. Le refroidissement à l’hélium est complété par la technique du “sympathetic cooling” qui combine l’usage de l’effet Doppler et d’un refroidissement à effet Raman sur les ions de baryum qui sont voisins des ions ytterbium. L’interaction coulombienne entre les ions baruym permet de refroidir les ions ytterbium accolés aux ions baryum. L’effet Doppler consiste à envoyer des photons dont la fréquence est calibrée pour ralentir les ions qui se dirigent vers leur source tout en laissant en place ceux qui se dirigent dans l’autre sens. Une opération de refroidissement des ions baryum a lieu avant chaque exécution de porte à deux qubits.

Le refroidissement par laser des ions fonctionne en fait très bien à température ambiante et depuis plus de 30 ans. Comme de nombreux groupes de recherche, Honewyell refroidit le piège à ion (à 12,6K) pour minimiser l’effet d’échauffement anormal des ions, qui est un problème majeur des manipulations d’ions piégés et qui n’est d’ailleurs pas entièrement compris. Cet échauffement anormal est fortement réduit lorsque le piège est refroidi. C’est pour ça qu’ils le font ici.

Le système s’articule autour de briques de quatre qubits et utilise des portes quantiques à un et deux qubits qui sont activées par lasers, via l’effet Raman qui nécessite une paire de faisceaux. Les portes unitaires (un seul qubit) sont activées par une paire de faisceaux Raman de 370,3 nm en polarisation circulaire. Le système permet de générer des portes X, Y et Z pour qui effectuent des rotations de quarts de tours et de demi-tours autour des trois axes de la sphère de Bloch qui représente l’état quantique d’un qubit. Ces rotations se font avec une très grande précision d’après Honeywell. Cela assure un taux d’erreur minimum pour des portes quantiques unitaires (à un seul qubit).

Les portes à deux qubits utilisent deux paires de faisceaux laser additionnels qui agissent sur des paires d’atomes d’ytterbium qui ont été rapprochés l’un de l’autre par les électrodes de contrôle de positionnement du circuit. Deux ions sont ainsi déplacés par les électrodes dans le même puits de potentiel avant d’être couplés par laser. Les qubits peuvent alors être séparés et déplacés ailleurs pour interagir avec d’autres qubits.

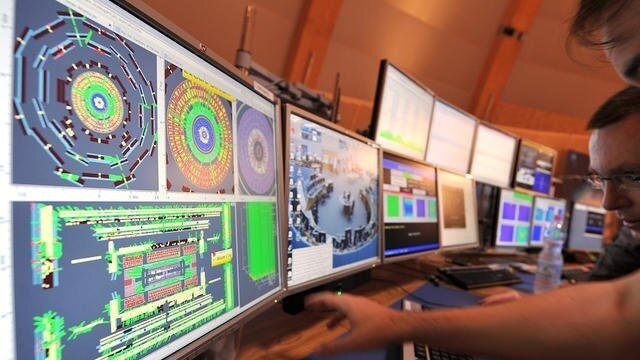

La lecture de l’état des ions se fait avec un imageur classique qui détecte l’état énergétique des ions via leur fluorescence qui est activée par laser. Cet imageur est un “PMT array”, c’est-à-dire un réseau linéaire de photomultiplicateurs (Photo-Multiplier Tube). Leur architecture permet une mesure de l’état des qubits en cours de traitement, sans perturber les qubits voisins. Cela permet de programmer l’ordinateur quantique avec une logique conditionnelle, avec des IF THEN ELSE comme en programmation classique.

Enfin, le système comprend un circuit électronique programmable FPGA pour le contrôle des qubits, à priori, hors de l’enceinte cryogénique.

Honeywell ne parle pas trop des méthodes et outils de programmation de leur processeur quantique. Elle doit être légèrement différente de celle des ordinateurs quantiques d’IBM et de Google du fait que les qubits peuvent se déplacer. La gestion temporelle de l’ensemble est aussi très différente du fait du temps de préparation des qubits pour les portes unitaires et les portes à deux qubits.

Importance de l’annonce

Une fois que l’on a éliminé le marketing du volume quantique et de l’ordinateur quantique le plus puissant du monde, que retenir d’intéressant ?

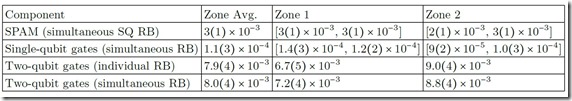

La performance de leurs qubits semble correcte, mais pas forcément extraordinaire en comparaison des valeurs déjà obtenues avec des ions piégés. Il existe plein de manipulations d’ions piégés avec beaucoup plus que 4 qubits. Chez Honywell, le taux d’erreur ne serait que de 2% après l’exécution d’une centaine de portes quantiques. Cela permettrait d’exécuter des algorithmes quantiques “profonds” avec un grand nombre d’enchaînements de portes quantiques.

Cela se compare à une profondeur d’environ 20 portes quantiques exécutées avec les 53 qubits supraconducteurs du chipset Sycamore de Google pour leur suprématie quantique de 2019. Il y aurait aussi un faible “cross talk” entre couples de qubits, à savoir que les qubits indépendants n’ont pas l’air d’interférer avec leurs voisins, sauf lorsqu’ils sont intriqués. Bref, ce taux d’erreurs très bas est un record à ce jour. C’est un saut qualitatif important dans le calcul quantique qui ouvre la voie à d’autres progrès pour avancer dans la création de calculateurs NISQ (Noisy Intermediate Scale Quantum). C’est extrêmement encourageant et probablement aussi important que la suprématie quantique de Google.

La principale nouveauté de l’expérience d’Honeywell est cependant de démontrer le déplacement physique des ions pendant les opérations de logique quantique. Ce n’est pas du tout une idée nouvelle, puisqu’elle a été proposée en 2002 par Dave Wineland and co. Cela en serait la première réalisation complète même si elle est encore primitive. En soi, elle est suffisamment impressionnante. C’est le résultat d’un gros travail d’ingénierie.

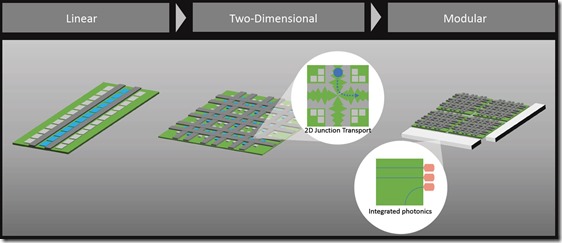

Honeywell indique que son architecture serait scalable, en conservant ce faible taux d’erreurs. Ils n’ont à ce jour testé que quatre qubits ! Ils envisagent une approche de montée en puissance à trois étapes. Pour l’instant, ils utilisent une barre d’ions piégés “1D”. Dans les deux étapes suivantes, ils passeraient à une barre en “2D” qui permettrait de déplacer les ions dans deux directions, permettant ainsi d’en accumuler un plus grand nombre et de les connecter avec leurs voisins dans deux dimensions. Cela prendra du temps de mettre cela au point.

Honeywell annonce ainsi que leur processeur sera 100 000 fois plus rapide d’ici 2025. Rapide comment ? Evalué avec le volume quantique d’IBM ou avec une autre méthode de mesure ? On ne sait pas. Par le passé, nombre d’annonces de ce genre ont été faites, comme John Martinis qui déclarait en 2017 scaler jusqu’à 72 qubits. Et ils en étaient à 53 en 2019. La scalabilité des processeurs quantiques est un des problèmes les plus complexes qui reste à régler.

Terminons cette partie par quelques mots de l’approche générale d’Honeywell. Ils ont démarré leurs investissements dans le calcul quantique en 2016 mais en mode “stealth”, sans communiquer autour. Cela se savait cependant car ils ont recruté des chercheurs issus de diverses universités américaines. Leur équipe rassemble aujourd’hui une centaine de personnes avec des physiciens, des ingénieurs et des développeurs.

J’ai repris la liste des signataires du papier scientifique d’Honeywell pour voir d’où ils venaient. Nous avons Juan Pino, John Gaebler, Michael Foss-Feig et Karl Mayer qui viennent de l’Université du Colorado, ces deux derniers étant passés par le NIST, l’équivalent de l’AFNOR français, qui investit beaucoup sur les technologies quantiques et leur standardisation. Karl Mayer a aussi travaillé sur les fermions de Majorana. Il y a aussi Joan Dreiling qui vient du laboratoire de physique de l’Université de Nebraska. Nous avons Caroline Figgatt et Steven Moses qui viennent de l’Université du Maryland et de l’équipe de Christopher Monroe, le fondateur d’IonQ, une startup qui explore aussi le calcul quantique à base d’ions piégés. Et puis Charles Baldwin du NIST et de l’Université du Nouveau Mexique, David Hayes de l’Université de Sydney et de Lockheed Martin, Ciaran Ryan-Anderson de l’Université du Nouveau Mexique, passé par les Sandia Labs et l’Université de Swansea au Royaume-Uni. Et enfin, Brian Neyenhuis de l’Université du Colorado et du Maryland. Pourquoi autant de scientifiques provenant du Colorado ? Parce que l’équipe quantique d’Honeywell est basée à Denver ! Et aussi un laboratoire du NIST qui planche sur le quantique !

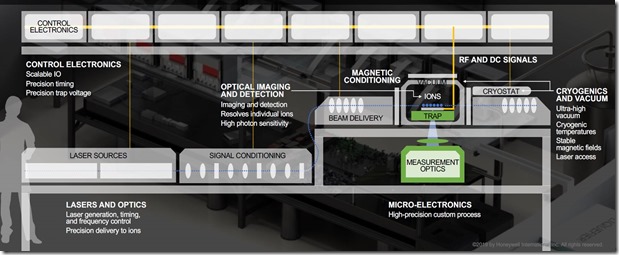

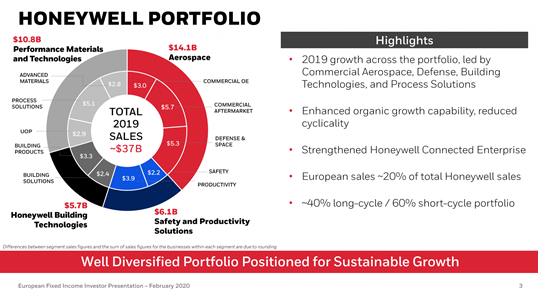

Du côté ingénierie, Honeywell n’est pas très disert sur la manière dont sont conçus leurs prototypes d’ordinateurs quantiques. On sait par contre qu’ils réutilisent des technologies qu’ils maîtrisent déjà du fait de leurs business traditionnels : en cryogénie, de création d’ultravide, de fabrication de MEMS, de générateurs d’ondes radio, de lasers et optiques. Ils sont notamment très présents dans l’aviation (APU, les unités de génération de puissance auxiliaires ainsi que dans les boîtes noires), le spatial, l’internet des objets, l’air conditionné, l’énergie, la chimie et les matériaux spéciaux.

Au moment de l’annonce du 2 mars, Honeywell évoquait plusieurs partenariats :

- Un partenariat avec Microsoft, dans la lignée d’une annonce de ce dernier faite en décembre 2019. À terme, les calculateurs quantiques d’Honeywell seront proposés dans le cloud Azure aux clients de Microsoft. Pour ce faire, il serait cependant utile d’attendre qu’ils puissent aligner au moins une quarantaine de qubits car en-deçà, on peut les émuler assez facilement sur des architectures traditionnelles.

- Un investissement dans les startups Cambridge Quantum Computing (2014, UK, $22,4 levés en tout) et Zapata Computing (USA). Startups qui développeront des outils logiciels pour les machines d’Honeywell.

- Un partenariat avec JPMorgan Chase pour créer des algorithmes quantiques dans le secteur financier. Cela permet d’aligner un client potentiel… face à la centaine qu’IBM affiche depuis janvier 2020.

Du côté de leur concurrence, la principale est celle d’IonQ (2016, USA, $75M), la spin-off de l’Université de Maryland. Ils ont réalisé en 2019 un processeur quantique de 160 qubits à base d’ions d’ytterbium avec un calcul réalisé sur 79 d’entre eux. Mais pour l’instant, leur benchmark publié se limite à 11 qubits, vu dans Benchmarking an 11-qubit quantum computer, mars 2019 (8 pages). Il faut aussi compter avec Alpine Quantum Technologies (2017, Autriche), créée par Rainer Blatt et qui a caractérisé jusqu’à 10 qubits à ions piégés de très bonne qualité.

Il y a aussi la startup de Yann Allain en France, NextGenQ, qui ambitionne aussi de créer un ordinateur quantique à base d’ions piégés, semble-t-il avec une technique voisine de celle d’IonQ mais avec des moyens très limités. Son créateur a déjà réussi à piéger quelques ions dans son système créé dans un garage ! Voir la vidéo d’une conférence où il intervient pendant une heure en décembre 2019.

Au passage, une petite remarque sur les rumeurs que j’entends souvent sur les capacités quantiques cachées supposées de la NSA aux USA. Comme quoi ils disposeraient de capacités de calcul quantique énormes non encore révélées. Genre, avec de quoi casser les clés RSA avec du calcul quantique (qui nécessite 23 millions de qubits de très bonne qualité pour une clé 2048 bits). L’épisode d’Honeywell montre que ce n’est probablement pas le cas. L’innovation dans le calcul quantique est incrémentale et distribuée dans le monde entier. Les chercheurs naviguent entre universités, entreprises et startups. Enfin, les grandes agences américaines reposent sur le secteur privé pour la plupart de leurs besoins technologiques. Il se dit par exemple que la NSA se repose sur Lockheed Martin pour tester des calculateurs quantiques comme ceux du canadien D-Wave. Ils ont cependant leur propre laboratoire de recherche, le NSA Laboratory for Physical Sciences (LPS), géré en partenariat avec l’Université du Maryland.

Conséquences pour la France

L’annonce d’Honeywell a beau devoir être prise avec quelques pincettes, notamment pour ce qui est de ce “record du monde” et du volume quantique mesuré avec l’indicateur d’IBM, c’est une performance intéressante. Elle montre que l’on peut stabiliser des qubits bien mieux qu’auparavant. Cela nous habitue à une nouvelle importante au moins tous les six mois, après celle de la suprématie quantique de Google de septembre/octobre 2019.

Cela illustre aussi la saine concurrence entre les différents types de qubits. Google et IBM, avec le qubits supraconducteurs et Honeywell avec les qubits à ions piégés. Lors de l’été 2019, les Chinois avaient fait des progrès avec des qubits à base de photons. Les français de Pasqal avancent bien de leur côté avec des qubits à base d’atomes froids et on s’affaire à Grenoble autour des qubits silicium. Sans compter les dizaines d’autres laboratoires de recherche en France et dans le monde.

Quelques autres enseignements sont à tirer que voici.

L’importance de l’ingénierie et de l’intégration : il faut assembler des équipes pluridisciplinaires avec une expérience des laboratoires de recherche (docs, post-docs) et dont une partie est passée par l’industrie. L’ingénierie quantique est clé pour fabriquer ces calculateurs quantiques complexes, en liaison avec la physique fondamentale. J’en avais décrit les contours dans un article précédent, Le développement des compétences en technologies quantiques.

La taille critique d’une équipe pour réaliser une telle performance est d’une centaine de personnes. C’est un niveau accessible à la recherche et à l’industrie française. Cela nécessitera cependant des efforts financiers qui devraient/pourraient arriver dans le cadre du plan quantique que l’État est en train de finaliser pour une annonce d’ici la fin du printemps 2020. Ce sont des investissements homothétiques avec ce qui existe à Grenoble, Paris et Saclay. Cela renforce le rôle d’animation et de coordination des hubs quantiques qui se sont constitués (à Saclay et Grenoble) et sont en passe de l’être (à Paris). On retrouvera à terme ce niveau d’investissement chez Atos.

La notion de timing et de rapidité est clé. Honeywell a aboutit à la performance annoncée en quatre ans. Les premières discussions sur un plan quantique français datent de 2018. Le plan doit être annoncé d’ici l’été 2020, soit deux ans après pour une mise en œuvre pratique qui démarrera au mieux en 2021. Donc, en tout trois ans ! Soit 75% du temps qu’il a fallu pour Honeywell pour créer une équipe faisant avancer significativement l’état de l’art. La rapidité de décision d’une entreprise privée est meilleure que celle d’un Etat. ll se trouve qu’en Europe et en France, la recherche fondamentale et même appliquée dans les technologies quantiques est encore principalement une affaire de recherche publique.

Deux impératifs sont donc à avoir en tête : comme d’un côté rendre les processus de décision plus rapides dans le fonctionnement de la recherche publique et d’autre part, encourager les grandes entreprises à faire des paris audacieux autour des technologies quantiques. Et des paris dans la création de technologies quantiques, pas seulement du côté de leur utilisation comme on peut le faire chez Total, EDF et Airbus en France. Il se trouve qu’en France, nous avons Atos et Thales qui sont dans cette position. Mais ils ne peuvent pas mener tous les lièvres à la fois. Le premier est investi dans l’émulation de calculateurs quantiques, dans la création d’outils de développement et dans la cybersécurité tandis que Thales est focalisé sur la métrologie et la cryptographie quantique. A ce stade, cela fait donc reposer l’effort principal en R&D sur les ordinateurs quantiques sur la recherche publique.

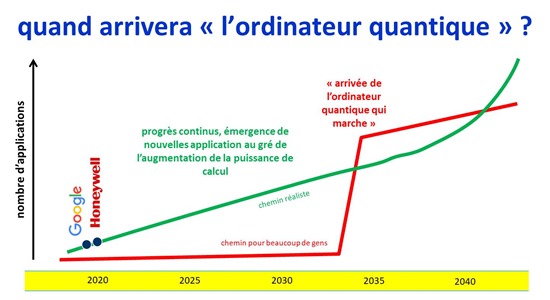

Enfin, les progrès dans le calcul quantique sont continus. Il ne faut pas attendre “l’ordinateur quantique qui marchera” dans 5 à 30 ans. Il viendra petit à petit, étendant à chaque nouvelle étape l’étendue du possible et le champ des applications réalisables avec. Pour être de la partie, il faut jouer sérieusement et dès maintenant.

Je remercie les relecteurs/correcteurs de cet article qui m’ont notamment permis d’affiner l’interprétation scientifique de l’expérience d’Honeywell : Patrice Bertet (CEA-SPEC), Christophe Jurczak (Quantonation), Eleni Diamanti (CNRS-LIP6) et Harold Ollivier (CNRS-LIP6).

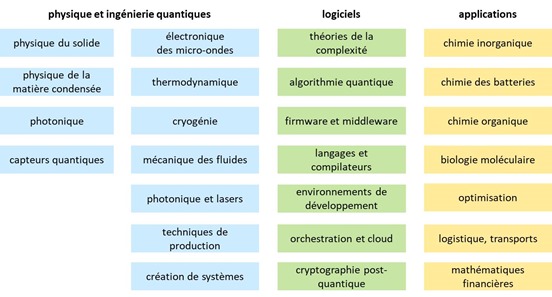

Le développement des compétences en technologies quantiques

Lorsque l’on veut préparer le futur et se positionner sur un secteur industriel en devenir, on pense immédiatement aux programmes de soutien à la recherche, aux startups et aux entreprises établies. Dans le cas des technologies quantiques, le financement de la recherche sera encore plus fondamental qu’ailleurs car elles sont encore en pleine phase de maturation. En amont de tout cela, il est aussi impératif de créer et entretenir un bon vivier de compétences, lancées par de la formation initiale et ravivées par toutes les formes de formations continues.

Il existe plusieurs méthodes pour ce faire. On associe traditionnellement des formations diplômantes et celles qui aboutissent à un doctorat (PhD). Cela rend les efforts de formation supérieure quasiment indissociables des efforts dans la recherche. Pour cette raison, former plus de scientifiques dans le quantique requiert une augmentation proportionnée des budgets dans la recherche.

Il faut y ajouter la formation continue dans les entreprises ainsi que les nombreuses méthodes d’auto-formation qui se développent dans tous les champs scientifiques.

Enfin, on peut aussi compléter l’ensemble en attirant des talents formés à l’étranger, ce qu’essayent de faire plus ou moins discrètement les Chinois mais que la France fait aussi régulièrement. Dans le quantique, nombre de nos chercheurs de pointe viennent ainsi de l’étranger et se sont installés durablement en France : Elham Kashefi (CNRS, Iran), Mazyar Mirrahimi (Inria, aussi Iran), Iordanis Kerenidis (CNRS, Grèce), Eleni Diamanti (CNRS, Grèce), Dominic Horsman (Université Grenoble Alpes, Royaume-Uni), Sara Ducci (CNRS, Italie), Virginia d’Auria (CNRS, Italie) et Silvano de Franceschi (CEA, Italie) pour ne citer que quelques-uns d’entre eux/elles. Ils/elles contribuent à la richesse de la recherche dans le pays, à l’encadrement de doctorants et à l’enseignement supérieur selon les cas de figure.

La planification de ces efforts dans le cas des technologies quantiques doit tenir compte de la grande diversité des métiers et compétences requises et aussi du fait que celles-ci vont très certainement évoluer graduellement dans le temps au rythme de la maturation de la discipline. Le succès des efforts français dépendra étroitement de la capacité du pays à créer et entretenir ce pool de compétences dans la durée.

Il nécessitera aussi de se différencier dans l’approche en mettant en avant l’interdisciplinarité du domaine, notamment via la notion d’ingénierie quantique. L’enjeu est de décloisonner au maximum les disciplines scientifiques et technologiques du quantique pour accélérer la génération d’innovations pratiques et industrielles. Cela pourrait amener à la création de trois types d’ingénieur(e)s quantiques : à dominante physique avec des bases en ingénierie, à dominante en ingénierie avec des bases en physique quantique et à dominante informatique avec des bases en physique et ingénierie quantique. Le succès de la filière quantique française reposera sur l’association étroite des trois. Sans compter toutes les compétences avales de la création de produits et/ou de startups avec leurs dimensions production, marketing et business.

Côté volumétrie, les besoins seront limités au début et grandiront progressivement. On ne travaille cependant pas sur les mêmes ordres de grandeur que dans l’ensemble des industries du numérique ou du secteur de l’intelligence artificielle. On parle de quelques milliers de personnes seulement. À la clé de ces efforts, la fourniture en compétences aux laboratoires de recherche, aux startups et aux entreprises qui se développeront grâce aux technologies quantiques et en particulier à l’export. Le Rapport Forteza évoque la création de 50 startups et la création de 5000 emplois en une dizaine d’années.

Le timing est clé et il faudra se préparer pour ne pas être à cours de compétences lorsqu’on en a besoin mais aussi ne pas en avoir trop au risque de décourager les jeunes et moins jeunes formés. Même si l’Histoire de l’Intelligence Artificielle a montré que les scientifiques formés pendant les hivers de l’IA se sont bien recasés ailleurs avant que l’IA ne revienne à la mode à partir d’environ 2015.

C’est de tout cela que traite ce texte qui contient au passage quelques pistes de réflexion. L’idée est aussi de susciter des vocations, aussi bien chez les jeunes que pour des adultes en mal de nouveautés.

Une des priorités du Rapport Forteza

En toute logique, l’une des recommandations clés du rapport Forteza sur le quantique est de développer les formations supérieures sur le quantique. Voir “Quantique : le virage technologique que la France ne ratera pas”, lien pour le téléchargement et vidéo de l’événement du 9 janvier 2020. C’est page 57 : “développer des nouvelles filières de formation initiales et continues de chercheurs, d’ingénieurs et de techniciens en soutien à l’écosystème quantique“.

Dans un premier temps, la task force pilotée par l’État doit remettre ses conclusions et recommandations d’ici fin mars 2020. Elle rassemble des représentants de l’Etat, des laboratoires de recherche et des organismes de financement comme l’ANR et Bpifrance. Ensuite, les arbitrages interministériels et au niveau de Matignon et de l’Élysée permettront de finaliser un plan quantique pour le pays. Il pourrait être annoncé à partir d’avril 2020, soit un an après le début des travaux de la mission Forteza.

En pratique, les centres de décision pour avancer côté formation sont assez décentralisés. Une bonne partie des besoins ont déjà été inventoriés par les deux premiers “hubs” quantiques lancés en France : celui de Paris Saclay, dénommé Quantum, et dont la création avait été annoncée le 26 novembre 2019, puis celui de Grenoble, QuEnG pour Quantum Engineering Grenoble. Ils sont pilotés respectivement par Pascale Senellart et Alexia Auffèves, deux Directrices de Recherche du CNRS très engagées dans le développement de ces écosystèmes. Un troisième hub devrait prendre forme cette année sur Paris intra-muros.

Ces hubs se sont donnés comme mission – entre autres choses – d’identifier les parcours de formation initiale nécessaires, les enseignants et les opportunités de mutualisation entre établissements. Ils sont les fédérateurs d’écosystèmes d’innovation décloisonnant la recherche fondamentale, de l’ingénierie et de l’industrie. Les trois doivent développer leur créativité en parallèle pour faire avancer les technologies quantiques dont on ne peut pas encore prédire avec certitude les débouchés. Ils ont ainsi vocation à devenir des creusets d’innovations encore en devenir.

État des lieux

Le pays compte plusieurs dizaines de laboratoires dans le quantique, presque tous des UMR du CNRS (Unités Mixtes de Recherche associées à des Universités) ou des laboratoires du CEA et de l’Inria. La dernière édition de l’ebook “Comprendre l’informatique quantique” (septembre 2019, 504 pages) en contient une cartographie.

C’est là que l’on trouve les doctorants, post-doctorants, chercheurs et enseignants-chercheurs. La majorité de ces laboratoires planchent sur la physique quantique fondamentale et expérimentale. Certains se rapprochent de l’informatique quantique dans ses grandes branches : calcul et simulation, télécommunications et cryptographie et enfin, métrologie.

Quelques laboratoires ont même engendré directement ou indirectement la création de la majorité des startups quantiques du pays que sont Aurea Technology (source de photons jumeaux), Pasqal (accélérateur quantique à base d’atomes froids), CryptoNext (cryptographie post-quantique), Veriqloud (middleware de télécoms quantiques), C12 (qubits à base de nanotubes de carbone), Alice&Bob (qubits supraconducteurs à faibles taux d’erreur), Cryoconcept (cryostats), Muquans (microgravimètres quantiques) et Quandela (sources de qubits photoniques). Ceci montre à quel point la recherche joue un rôle critique dans ce secteur d’activité émergent.

Autour ou à côté de ces laboratoires ont récemment émergé les premières formations sur l’informatique quantique proprement dite avec un mix de physique et de développement de logiciels quantiques. C’est notamment le cas dans quelques grandes écoles (ENS Ulm, ENS Paris Saclay, ENS Lyon, CentraleSupelec, Télécom Paristech, ISAE-Sup Aero, INSA de Toulouse, CPE Lyon, Epitech Lyon, ISEN) ainsi que dans certaines universités (Université Côte d’Azur, Sorbonne Université, Paris Diderot, Université Paris Saclay en partenariat avec CentraleSupelec, Université Paul Sabatier de Toulouse en partenariat avec l’INSA, UGA à Grenoble, Université de Lorraine, Université de Montpellier en partenariat avec IBM…) et même dans les écoles d’informatique privées (comme Supinfo, ECE, etc).

Diversité scientifique du quantique

Rien que dans le calcul quantique, il existe plusieurs filières physiques de réalisation de qubits. Elles correspondent à autant de branches qui se répartissent en trois grandes catégories : la manipulation d’atomes qui sont soit neutres soit ionisés, en général avec des lasers, celle d’électrons dans des matériaux supraconducteurs et/ou semi-conducteurs puis celle de photons qui traversent des guides de lumière, des prismes et autres interféromètres dits “de Mach-Zehnder”. Et c’est juste pour la partie “physique fondamentale” ! Vu de loin, ces branches de la physique se concurrencent, mais vu de près, elles se complètent souvent. Ainsi, la photonique joue-t-elle un rôle indispensable à toutes les autres branches pour transporter des qubits à moyenne et longue distance ou pour activer des qubits non photoniques. De même, les atomes froids peuvent aussi bien servir à créer des qubits que de la mémoire quantique éventuellement exploitable par d’autres formes de qubits.

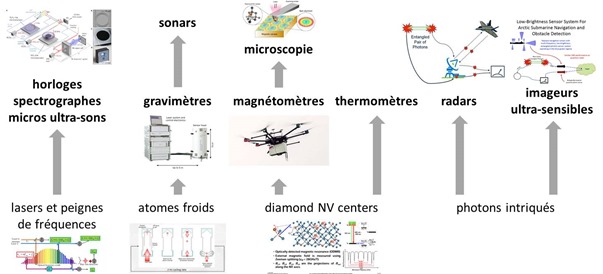

D’autres filières quantiques spécialisées existent dans les télécommunications et la cryptographique quantiques, qui s’appuient sur de la photonique, ainsi que dans la métrologie, avec encore une fois, une très grande diversité de technologies et donc de compétences. Je reprends ci-dessous l’illustration maison extraite de la dernière version de mon ebook. La diversité de la métrologie quantique est aussi grande que dans les qubits. On y trouve de la photonique, de la physique de la matière condensée, des atomes froids piégés par des lasers et des cavités dans des diamants où l’on contrôle le spin d’électrons.

De concert avec la physique fondamentale, on a besoin d’ingénierie de systèmes pour créer de véritables machines qui fonctionnent de bout en bout. Cela nécessite de décloisonner les disciplines et de rapprocher les physiciens des ingénieurs. Les technologies mises en jeu sont variées et incluent la photonique et les lasers, l’électronique analogique et numérique, notamment avec les micro-ondes, la thermodynamique, la mécanique des fluides, l’ingénierie de production de composants diverses et enfin, la conception de systèmes complets.

La photonique joue un rôle de soutien dans de nombreuses technologies quantiques. Le contrôle par lasers est au cœur des qubits à base d’atome froids et d’ions piégés, mais aussi pour de nombreux qubits de spin au cœur des relais quantiques. Suivant les applications envisagées, les lasers sont des produits standards ou développés avec des caractéristiques particulières et leur paramétrage et leur manipulation demandent des compétences spécifiques. Le développement de puces photonique de grande transparence ou permettant de manipuler la lumière sur puce est essentiel pour la miniaturisation des processeurs quantiques optiques mais aussi pour développer des systèmes de cryptographie compacte ou des horloges atomiques ou capteurs inertiels compacts. Enfin, la détection de lumière quantique de grande efficacité est une autre ressource essentielle pour aussi bien pour les processeurs quantiques optiques que pour les communications quantiques de longue distance.

L’électronique, principalement dans les micro-ondes intervient dans la conception et/ou l’usage de générateurs de micro-ondes, ces dernières étant envoyées vers les qubits par des câbles coaxiaux qui permettent d’en contrôler l’état. Elle intervient aussi dans les circuits de préamplification qui doivent fonctionner généralement à température cryogénique et supraconductrice, pour les qubits à base d’électrons en général. Les générateurs de micro-ondes sont des produits génériques du marché, mais on peut être amené à en créer de spécifiques selon les besoins. Tout ceci se fait à des fréquences situées entre 5 et 10 GHz. Il faut aussi créer ou utiliser des guides d’ondes pour véhiculer ces micro-ondes jusqu’aux qubits.

La thermodynamique entre en jeu à plusieurs niveaux dans les ordinateurs quantiques, dans ses aspects les plus pratiques comme les plus fondamentaux. Du point de vue pratique, dans l’enceinte cryogénique d’un ordinateur quantique à base d’électrons (qubits supraconducteurs à effet Josephson comme chez Google et IBM ou à spin d’électrons comme ce sur quoi se focalise le CEA-Leti), le budget thermique qui peut être consommé par l’électronique embarquée est limité par la capacité de refroidissement des cryostats. Du point de vue fondamental, il est ni plus ni moins question que d’établir une loi de Moore pour la consommation énergétique. Les portes logiques quantiques consomment une énergie qui peut rapidement devenir non négligeable au vu des nombres de portes mises en jeu, en particulier lorsque le nombre de qubits augmentera significativement (dans le “Large Scale Quantum computing”, souvent appelé LSQ). D’autre part, le traitement de l’information lui-même peut induire des coûts liés à sa nature irréversible. On parle ici de milliwatts, pas des 300W de consommation d’un GPU Nvidia V100 ! L’enjeu sera de concevoir des systèmes extrêmement économes du côté de la consommation d’énergie, et relever ce défi requiert d’être capable de construire une véritable alliance de l’ingénierie et de la physique fondamentale.

La mécanique des fluides intervient dans la conception et l’usage des cryostats qui refroidissent une bonne partie des ordinateurs quantiques ou d’une partie de leur appareillage. L’enjeu est de créer de tels cryostats qui perturbent le moins les qubits et d’autre part, de les miniaturiser, en particulier dans les applications de métrologie quantique. Les fluides utilisés sont de l’azote liquide et deux isotopes de l’hélium (3 et 4) qui ont des propriétés particulières qu’on appelle la superfluidité et qui jouent un rôle dans le refroidissement.

Les techniques de production des composants des processeurs quantiques et périphériques font appel à l’arsenal des outils de production de semi-conducteurs CMOS en silicium ou en matériaux semi-conducteurs III-V comme le gallium ou l’indium, ou encore de micro-électronique et de MEMS (micro-electro-mechanical-systems). Ces techniques sont maîtrisées à différents endroits en France comme au C2N du CNRS à Palaiseau ou au sein des autres sites du réseau de technologie RENATECH, au CEA-Leti à Grenoble, chez STMicroelectronics à Crolles près de Grenoble, mais aussi chez Thales à Palaiseau. Sachant que même là, il existe des variantes entre la maîtrise de procédés de production de matériaux de pointe aux propriétés quantiques (C2N, FEMTO-ST de Nancy, IEMN de Lille, LAAS-CNRS de Toulouse, Thales), le développement des procédés pré-industriels (CEA-Leti) et et la production en volume (STMicroelectronics, même si leur engagement dans la filière quantique n’est pas garanti). Sur certains niveaux d’intégration en-dessous du 20 nm, il faut passer par de la sous-traitance chez des fondeurs tels que TSMC à Taiwan.

Enfin, il faut concevoir des systèmes complets avec leur ordinateur classique de pilotage, le contrôle des dispositifs électroniques de l’ordinateur quantique, celui du cryostat, des composantes réseaux classiques ou optiques/quantiques et une bardée de capteurs divers. Le tout à un cout contrôlé et compétitif par rapport à l’état de l’art du marché. Il faut être capable de fabriquer et assembler tout cela. Il est aussi important de s’approvisionner en matière premières nécessaires à la création de tous ces systèmes (terres rares, hélium 3 et 4, silicium gazeux d’isotope 28 pour les qubits CMOS, connectique supraconductrice, etc).

Ensuite, dans les domaines purement mathématiques et logiciels entrent en jeu des disciplines très importantes pour pouvoir créer des solutions quantiques de bout en bout :

- Les théories de la complexité pour la conception d’algorithmes efficaces et leur classification ainsi que l’estimation de leurs gains opérationnels par rapport à des algorithmes classiques.

- La création de ces algorithmes quantiques requiert une grande capacité d’abstraction et, en tout cas aujourd’hui, celle de l’algèbre linéaire avec des matrices de nombres complexes, des, espaces de Hilbert et tout le toutim. Cette création continuera d’aller de plus belle au gré de l’augmentation de la performance des ordinateurs quantiques. Elle concerne aussi le champ spécifique des codes de correction d’erreurs ainsi que celui des algorithmes hybrides qui associent du calcul classique et du calcul quantique. Dans ce dernier cas, les créateurs d’algorithmes devront avoir une double compétence associant les méthodes traditionnelles, tournant notamment sur supercalculateurs et/ou GPU ou même NPU (Neural Processing Units utilisés notamment dans le deep learning) et les méthodes quantiques.

- La création de firmwares qui servent à piloter les outils de contrôle des qubits. Il s’agit d’ordonnancer les commandes de contrôle des qubits : portes logiques, coupleurs pour les intriquer et mesure des états en fonction de leurs caractéristiques physiques. Le tout avec des compilateurs qui transforment le langage de contrôle des qubits en commandes physiques de ces derniers. C’est une des activités de l’équipe quantique d’Atos.

- La création et l’amélioration d’outils de développement visuels pour faciliter le travail des développeurs. Il arrivera peut-être un jour où l’on pourra programmer des logiciels quantiques sans connaître le sous-jacents quantiques des calculateurs. De nouvelles catégories de middleware feront leur apparition pour simplifier le travail des développeurs comme pour les aider à gérer des traitements quantiques répartis (le champ d’action de la startup française Veriqloud).

- L’orchestration de l’ensemble requiert la création d’outils de gestion de batches de processus de calculs quantiques, ce d’autant plus qu’une bonne part des ordinateurs quantiques sont déployés dans le cloud et y resteront.

- Ajoutons à la partie informatique le champ ouvert de la cryptographie post-quantique. Il est périphérique à l’informatique quantique car il s’agit de moyens de chiffrement à base de clés publiques qui servent à se protéger contre les futures capacités de cryptographie (cassage de clés publiques) des ordinateurs quantiques. Les besoins existent déjà. Nous avons une startup française spécialisée dans le domaine, CryptoNext. La standardisation du domaine est en cours et pourrait aboutir d’ici 2024, en tout cas au NIST américain qui a vu de nombreux laboratoires français y contribuer. Cela veut dire que les déploiements vont commencer au milieu des années 2020. Là encore, cela génèrera un appel d’air en compétences.

Toutes ces disciplines informatiques doivent évoluer de concert avec la partie physique et technologique des systèmes quantiques. En l’état actuel de l’art, on ne peut pas isoler le matériel du logiciel comme on le fait dans l’informatique traditionnelle. Les ingénieurs logiciels quantiques devront donc avoir des connaissances dans la physique quantique et les ordinateurs quantiques. Réciproquement, les concepteurs d’ordinateurs quantiques devront appréhender la manière dont ils sont pilotés et programmés.

Enfin, la création des applications métiers demande des compétences à la croisée des chemins entre celle du dessus et des compétences sectorielles, souvent elles-mêmes scientifiques comme dans les sciences du vivant (chimie organique, repliement des protéines, photosynthèse, …), les sciences des matériaux (comme dans la chimie des batteries au niveau des cathodes et anodes) ou d’autres branches comme les calculs de risques dans la finance ou les problèmes d’optimisation dans la logistique et les transports. C’est là que grandiront le plus les besoins en compétences au gré de l’augmentation de la puissance de calcul des ordinateurs quantiques. On en trouve déjà dans les premières grandes entreprises françaises qui se sont emparée du quantique, en particulier chez Total, EDF, Airbus et BNP où des dizaines d’ingénieurs et chercheurs sont déjà actifs autour des applications des technologies quantiques.

Jusqu’à présent, nous avons décrit des compétences mais pas forcément des métiers. Les métiers peuvent requérir plusieurs de ces compétences, notamment en fonction de la taille des équipes.

On peut distinguer en grosses mailles :

- Les physiciens de la physique fondamentale (physique du solide, de la matière condensée, interaction lumière-matière, optique quantique) qui associent approches théoriques et expérimentales pour comprendre des phénomènes à bas niveau. Côté calcul quantique, l’augmentation du nombre de qubits et de portes logiques ne pourra se faire que grâce à de nouveaux sauts conceptuels.

- Les chercheurs en technologies quantiques qui transforment les découvertes fondamentales en premières preuves de concept en laboratoire. Ces équipes de recherche combinent des chercheurs en physiques, des chercheurs en technologies et ingénierie.

- Ils s’appuient parfois sur des techniciens de laboratoires qui installent et pilotent les nombreuses manipulations expérimentales.

- Des ingénieurs de conception qui créent des sous-ensembles techniques d’ordinateurs quantiques jusqu’à des produits finis complets. Ils font essentiellement le “D” de la “R&D” en s’appuyant sur le R des physiciens.

- Des ingénieurs de recherche, qui participent au développement des nouveaux matériaux et nouvelles technologies dans les centrales RENATECH comme le C2N à Palaiseau ou dans la salle blanche de Thales TRT, ou des ingénieurs procédés qui conçoivent les processus de fabrication de ces systèmes de circuits intégrés supportant les qubits au CEA-Leti.

- Des techniciens pour la fabrication de certains composants et/ou pour le déploiement de technologies comme la cryptographie quantique dans l’univers des télécoms. Mais seulement une fois que cette technologie sera déployée à l’échelle industrielle, probablement par des opérateurs de télécommunication généralistes ou spécialisés.

- Des développeurs d’outils de développement qui doivent être associés aux chercheurs et ingénieurs précédents. En effet, pour l’instant, la conception de ces outils doit encore tenir compte des spécificités physiques des calculateurs/accélérateurs quantiques.

- Des développeurs d’applications, qui seront de plus en plus nombreux au gré de l’augmentation de la puissance de calcul des ordinateurs quantiques.

- Des chefs de projets qui gèrent des projets associant ces différents métiers.

Comme dans de nombreuses disciplines, les chercheurs et ingénieurs doivent de plus en plus être polyvalents. Les équipes doivent s’articuler autour d’une forte interdisciplinarité et transversalité. Elles ont besoin de “polyglottes technologiques” qui relient tous ces métiers et toutes ces compétences. Les physiciens devront notamment s’intéresser de plus en plus à l’ingénierie et les ingénieurs à la physique. Dans le quantique, les deux sont étroitement associés (évitons les jeux de mots habituels…).

Enfin, lorsque l’on arrive au “business” avec des produits qui peuvent être commercialisés, il faut ajouter tout le mixte des compétences habituelles de la vente de technologies : du marketing produit, du marketing opérationnel, du lancement de partenariats, de la création d’écosystèmes et surtout, de la vente pure et simple en mode B2B. S’y ajoutent les compétences génériques de la création de startups dans l’univers des deep techs (organisation, business planning, recrutement, financements, etc).

Il faut compléter cela par des conseils en propriété industrielle qui doivent se coltiner les spécificités du vocabulaire du quantique ainsi que des contributeurs aux divers processus de standardisation qui ne manqueront pas d’émerger.

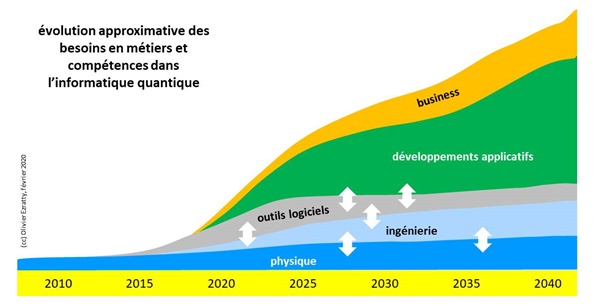

Évolution des besoins dans le temps

Le mix des compétences évoquées ci-dessous va évoluer au gré de la maturation des technologies quantiques. Elle est de niveau différent selon le domaine :

- Les produits de la métrologie quantique commencent à être commercialisés, comme les gravimètres de Muquans et sur un marché pour l’instant de niche mais qui pourrait devenir un marché de volume comme l’envisage Thales dans les capteurs de position. De nombreux autres capteurs quantiques sont en développement à base de cavités de diamants, de lumière quantique ou de résonateurs optomécaniques qui arriveront sur le marché dans la décennie qui vient.

- Les systèmes de cryptographie quantiques sont en phase expérimentale terrain et pourraient être déployés à plus grande échelle dans la décennie qui vient. Les communications quantiques dont l’objectif est de conduire à des réseaux de communications quantiques se développeront dans un second temps, combinant réseau fibré et satellite, avec relais quantiques. C’est un domaine complémentaire du développement des ordinateurs quantiques qui seront mis en réseau grâce à ces nouveaux moyens de communication.

- Enfin, le calcul et la simulation quantiques vont évoluer progressivement et voir leur champ applicatif s’élargir au gré de l’augmentation du nombre de qubits de qualité disponibles dans les calculateurs quantiques. Ce sera un processus d’innovation continu. Il passera par différentes étapes transitoires comme le NISQ (“noisy intermediate-scale quantum”) qui décrit les ordinateurs quantiques actuels et des 10 prochaines années qui utilisent des qubits “bruités” imparfaits. Avant que l’on puisse utiliser des qubits en très grande quantité, au-delà de 100, bruités et intégrant des systèmes de corrections d’erreurs.

Comme c’est le cas dans l’informatique traditionnelle, le poids du logiciel est amené à terme à devenir dominant dans les besoins en compétences. Cela explique pourquoi nombre de publications insistent sur le besoin en développeurs d’applications quantiques. C’est ce sur quoi “évangélisent” les grands acteurs que sont IBM, Google et Microsoft, sans compter D-Wave, Rigetti ou IonQ. Voir ainsi : Quantum Computing Demands a Whole New Kind of Programmer par Edd Gent, mai 2017 (un peu en avance de phase), The Hitchhiking Cat’s Guide to Getting a Job in Quantum Computing par Jay Gambetta, octobre 2019, Building Quantum Skills With Tools For Developers, Researchers and Educators, IBM Research, septembre 2019 et Some useful skills for quantum computing par Chris Granada, janvier 2020, qui insiste aussi sur les compétences mathématiques et logicielles.

Néanmoins, parallèlement au développement du marché logiciel, une phase intermédiaire demandera beaucoup de compétences en ingénierie et dans les différentes branches du quantique. C’est la voie indispensable de l’industrialisation des ordinateurs quantiques, tout du moins si la France veut avoir sa part du gâteau dans ces marchés de l’offre et pas seulement dans l’usage des technologies quantiques.

Les besoins sont aussi liés aux ambitions du plan quantique français qui devrait être publié d’ici la fin du printemps 2020. Il est estimé qu’il faudra passer de 300 à 400 chercheurs et ingénieurs permanents des technologies quantiques au quadruple dans la décennie qui vient. Cela reste des quantités raisonnables et sans commune mesure avec les besoins en compétences dans le numérique qui se chiffrent en dizaines de milliers de spécialistes. Mais comme elles sont très pointues, la tâche n’est pas moins ardue.

Il faut raisonner à l’échelle mondiale. Plusieurs plans à “plus d’un milliard” ont été récemment lancés : le plan Européen Quantum Flagship en 2018 (qui contient d’ailleurs un volet formation), le plan américain fin 2018 (qui pourrait être renforcé en 2020), le plan chinois depuis 2015, le plan du Royaume Uni depuis 2013 et le plan Indien en janvier 2020. L’Allemagne a annoncé en 2018 un plan de 650M€. Des scientifiques israéliens militent pour un plan de $350M. Un plan du même ordre de grandeur a été annoncé en Russie en 2019. Tout cela créé un appel d’air mondial pour le développement des compétences dans le quantique. Comme pour l’IA, cela va entraîner une concurrence inter-états et des transferts entre pays.

Comment s’organiser

C’est un peu le rôle des “hubs quantiques” que de mettre en musique les efforts en termes de formations (et pas que). Ils vont coordonner la création de cursus complémentaires, d’assurer une volumétrie en phase avec des besoins, et en avance de phase. Dans certains cas, des formations pourront être mutualisées entre plusieurs établissements supérieurs (grandes écoles, universités), surtout lorsque les compétences d’enseignement sont rares.

La formations dans l’enseignement supérieur public devra introduire les sciences et technologies quantiques le plus en amont possible des cursus aux niveaux licence et master. Il faudra aussi y créer des masters en ingénierie quantique, rapprochant le monde de la recherche et de l’ingénierie. L’offre de formation dépendra de plusieurs paramètres : des financements de postes d’enseignants chercheurs ou d’enseignants, de la création de vocations, de la capacité à les attirer les enseignants et les étudiants, d’où qu’ils viennent. Cela passera par le développement de l’attractivité de l’offre en France. Il faudra pour la partie fondamentale générer autant de doctorants que possible pour les formations scientifiques et développer les thèses CIFRE avec les industriels. Et côté ingénierie, l’offre de formations devra être en phase avec la capacité de l’industrie à proposer de stages de longue durée. Ces stages seront probablement proposés par des entreprises et startups aussi bien françaises qu’étrangères. Des entreprises qui seront donc naturellement intégrées dans les hubs quantiques.

Les chaires industrielles jouent un rôle de passerelle entre les grandes entreprises, la recherche et l’enseignement supérieur. Atos en a créé une sur le quantique conjointement avec le CEA en 2018. Dénommée Nasniq (“Nouvelle architecture de spins nucléaires pour l’information quantique”), elle est portée par Daniel Estève du CEA-Saclay et couvre à la fois des aspects physiques (qubits supraconducteurs) et logiciels (programmation hybride). IBM a créé de son côté une chaire avec l’ESIEE Paris qui porte sur l’IA et les analytics qui aura accès aux outils de calcul quantique d’IBM.

La formation à la programmation quantique est déjà proposée par des entreprises américaines telles qu’IBM et Microsoft, ce dernier en partenariat avec Brilliant. Elles font de l’entrisme en France et partout ailleurs pour prendre place sur le marché via leurs outils de développement maison. Il va sans dire qu’il faudra équilibrer cela avec des outils open source et/ou des outils maison comme ceux d’Atos en ayant en tête de les diffuser aussi hors de France.

La formation continue pourra comprendre des cursus aussi bien scientifiques et technologiques (physique quantique, communications quantiques, algorithmes et logiciels quantiques) que stratégiques (compréhension des enjeux, connaissance des acteurs, économie du secteur, bonne pratiques). Elle peut ou pourra être délivrée par des organisations privées comme Capgemini Institut (où je délivre des séminaires de sensibilisation sur le sujet), par des organismes d’enseignement supérieur ainsi que via des cours en ligne proposés à différents endroits (Coursera, …). Alain Aspect propose même un MOOC sur l’optique quantique en deux parties à l’Ecole Polytechnique. On trouve des Mooc chez Udemy. On peut évidemment en dénicher un bon nombre aux USA (Stanford, MIT, Coursera, …). Enfin, les pionniers des technologies quantiques des grandes entreprises françaises (Atos, Thales, Total, EDF, Airbus, BNP, …) pourront faire intervenir leurs cadres et chercheurs dans l’enseignement supérieur comme dans la formation continue.

L’auto-formation permet aux passionnés de découvrir par eux-mêmes ces sciences et technologies mais elle n’est pas autosuffisante comme c’et parfois le cas dans l’intelligence artificielle. Elle doit être complétée par un accompagnement pédagogique de qualité, ne serait-ce que pour faire et corriger des exercices. Pour ce qui est de la partie logicielle, cela changera peut-être le jour où les outils de développement auront un plus haut niveau d’abstraction que ceux d’aujourd’hui.

Les événements scientifiques organisés par les hubs quantiques, les laboratoires de recherche et les entreprises servent à faciliter la transdisciplinarité des chercheurs et des ingénieurs. Il peut s’agir de colloques interdisciplinaires, de conférences thématiques ou d’ateliers. L’un des bons exemples est la conférence du 27 novembre 2019 organisée par le C2N du CNRS et l’équipe mixte Thalès/CNRS pour croiser informatique quantique et processeurs neuromorphiques. Ce sont des mises en bouche qui doivent s’accompagner ensuite de formation et de temps pour approfondir les sujets découverts.

Il faudra aussi faire en sorte d’attirer autant de femmes que d’hommes dans ces cursus, au risque sinon, de voir se développer comme dans l’IA un secteur entier bien trop masculin. Sans compter l’augmentation de la diversité des origines sociales des étudiants qui reste un moyen de promotion républicain clé, malgré son déclin actuel.

En amont de tous ces cursus, la création de vocations chez les jeunes est indispensable. L’équipe de Paula Forteza avait fort à propos lancé une initiative dans ce sens avec une mini-exposition de vulgarisation du quantique à la Cité des Sciences en octobre/novembre 2019. Avec Fanny Bouton et Tara Mestman (15 ans), je suis intervenu chez Magic Makers en septembre 2019 devant une vingtaine de lycéennes (ci-dessus), puis le 29 février 2020 dans l’événement Startup4Teens (inscriptions) et enfin le 7 mars 2020 dans le programme de #laTechpourtoutes à l’Ecole 42 (inscriptions). Des actions à démultiplier si possible en région !

La fête de la science annuelle et les journées portes ouvertes des laboratoires de recherche peuvent aussi y contribuer. C’est un travail de longue haleine comme l’est la création de vocations dans les sciences en général et dans les métiers scientifiques et techniques du numérique en particulier.

/https%3A%2F%2Fprofilepics.canalblog.com%2Fprofilepics%2F4%2F2%2F426588.jpg)

/image%2F0964619%2F20240518%2Fob_e065e9_festival-du-livre-1920x1080-4-24-ecran.jpg)

/image%2F0964619%2F20240506%2Fob_4f0709_image-0991366-20181104-ob-95e079-jacqu.jpg)

/https%3A%2F%2Fstorage.canalblog.com%2F75%2F17%2F505612%2F129406040.jpeg)

/https%3A%2F%2Fstorage.canalblog.com%2F09%2F46%2F497307%2F133747489_o.jpg)